Заменит ли чат-бот психолога? Что ИИ может (и чего не может) сделать для психического здоровья

В последние годы разговоры о психическом здоровье перешли в цифровую плоскость. По мере развития искусственного интеллекта всё больше людей обращаются к чат-ботам, чтобы исследовать свои мысли и эмоции. Но могут ли эти виртуальные инструменты действительно поддерживать наше психическое здоровье значимым образом – или даже заменить традиционную психологическую помощь?

В этой статье мы исследуем реальные возможности и ограничения чат-ботов на базе искусственного интеллекта в контексте психического здоровья. Мы рассмотрим, что они могут делать, чего они абсолютно не могут, и как технология (при разумном использовании) может дополнять, но не заменять человеческое общение и профессиональную помощь.

Рост ИИ-компаньонов в сфере эмоциональной поддержки

Согласно Глобальной стратегии Всемирной организации здравоохранения по цифровому здравоохранению (2020–2025), цифровые технологии – включая искусственный интеллект – активно продвигаются для обеспечения универсального и равного доступа к качественным медицинским услугам и повышения эффективности системы.

Чат-боты на базе ИИ быстро стали частью обсуждений вопросов психического здоровья. Они доступны круглосуточно, никогда не осуждают и могут имитировать эмпатию в разговоре. Такие инструменты, как генеративные ИИ-ассистенты (включая ChatGPT) и другие специализированные приложения, теперь используются для разговоров о чувствах, преодоления ежедневного стресса и даже борьбы с одиночеством.

Эти чат-боты обычно работают на основе больших языковых моделей, обученных на огромных массивах человеческих диалогов. Некоторые из них основаны на правилах и предоставляют структурированную поддержку на основе заранее запрограммированных сценариев. Другие используют адаптивные алгоритмы, чтобы отражать тон пользователя или предлагать направленные упражнения по самопомощи.

Многие пользователи отмечают, что взаимодействие с чат-ботом помогает им почувствовать себя услышанными или понятыми – особенно когда у них нет немедленного доступа к профессиональной поддержке. В некоторых случаях эти инструменты могут предлагать полезные советы по управлению незначительным стрессом, установлению распорядка или практике осознанности.

Но это приводит к ключевому вопросу: действительно ли «чувство, что тебя услышали» от чат-бота превращается в психологическую поддержку – или это всего лишь её имитация?

Человеческий разум сложен – сможет ли ИИ с ним сравниться?

Хотя чат-боты могут вести удивительно естественные беседы, важно понимать, чем они не являются. Искусственный интеллект не обладает сознанием. Он не понимает контекста, эмоциональных нюансов или личной истории.

В отличие от квалифицированного специалиста, чат-бот не может:

- Оценить клинические симптомы

- Выявить основные причины дистресса

- Поставить диагноз

- Адаптировать терапевтические методы в соответствии с меняющимися потребностями человека

- Безопасно реагировать в кризисных ситуациях

Системам искусственного интеллекта не хватает человеческого суждения и этических основ, необходимых для настоящего психологического вмешательства. Даже самые продвинутые модели работают без эмоционального осознания – они распознают языковые шаблоны, а не реальные эмоции.

Хотя системы чат-ботов могут быть полезны для размышлений и структурированного самоконтроля, они не заменяют клиническую помощь и не предназначены для управления сложными эмоциональными состояниями.

Иллюзия поддержки: когда технологии кажутся более безопасными, чем они есть на самом деле

Одним из наиболее значительных рисков, связанных с чат-ботами в сфере психического здоровья, является иллюзия помощи.

Поскольку эти инструменты являются диалоговыми и всегда реагируют на запросы, пользователи могут почувствовать, что получают значимую поддержку, даже если это не так. В некоторых случаях люди могут заменить профессиональную помощь разговорами с чат-ботом, что может привести к задержке диагностики или оказания надлежащей помощи.

Это ложное чувство безопасности может быть особенно опасным в следующих ситуациях:

- Депрессия или суицидальные мысли

- Травма и посттравматический стресс

- Сложные тревожные расстройства

- Эмоциональная дисрегуляция

В независимых академических обзорах (Vaidyam et al., „Chatbots and Conversational Agents in Mental Health”) исследователи отмечают, что, хотя инструменты ИИ могут расширить доступ и обеспечить структурированное взаимодействие, они не предназначены для замены клинической помощи и могут не иметь необходимых протоколов для оказания сложной эмоциональной поддержки.

Это подчеркивает важную истину: технологии могут казаться эмпатичными, но они не понимают истинного дистресса.

Итак, что же на самом деле может сделать ИИ для нашего психического здоровья?

Вопрос не в том, может ли ИИ заменить психолога, а в том, как он может помочь вам по-другому.

Именно в этом ИИ и цифровые инструменты могут действительно изменить ситуацию.

1. Направленная саморефлексия

Некоторые инструменты ИИ предназначены для того, чтобы помочь пользователям в структурированной саморефлексии. Задавая открытые вопросы или предлагая пользователям описать свое текущее состояние, эти системы могут помочь людям выразить свои мысли и лучше понять, что они чувствуют. Например, чат-бот может спросить: «О чем вы думали сегодня?» или «Как бы вы описали свое текущее настроение тремя словами?»

Такие подсказки побуждают пользователей замедлить темп, понаблюдать за своим внутренним состоянием и развить более глубокое эмоциональное самосознание, что особенно полезно для тех, кому трудно назвать, регулировать или даже распознать свои эмоции. В психологии этот процесс часто называют «аффективной маркировкой».

Хотя такие взаимодействия не заменяют терапию или диагностику, они могут создать пространство для личного размышления и со временем помочь пользователям лучше настроиться на свои эмоциональные паттерны. В этом смысле ИИ может выступать в качестве поддерживающего зеркала, предлагая структуру для самоанализа без осуждения.

2. Приложения для осознанности и медитации

Некоторые платформы предлагают медитации с голосовым сопровождением, дыхательные упражнения и мягкие подсказки, чтобы проверить свои эмоции. Сеансы могут проводиться реальными коучами или с использованием голосов, сгенерированных искусственным интеллектом, в зависимости от приложения. Хотя это и не терапевтические меры, они могут помочь регулировать эмоции и снизить повседневный стресс.

Они также могут помочь пользователям выработать постоянный распорядок дня, способствующий спокойствию и сосредоточенности, особенно если использовать их в одно и то же время каждый день. Со временем использование этих инструментов может усилить чувство присутствия, помогая пользователям замечать, как меняются мысли и ощущения в течение дня.

3. Отслеживание настроения и поведения

Цифровые дневники настроения и платформы самооценки позволяют пользователям отслеживать закономерности в своих мыслях, сне, активности и концентрации. Со временем эти данные могут помочь выявить триггеры или факторы образа жизни, которые влияют на умственную работоспособность.

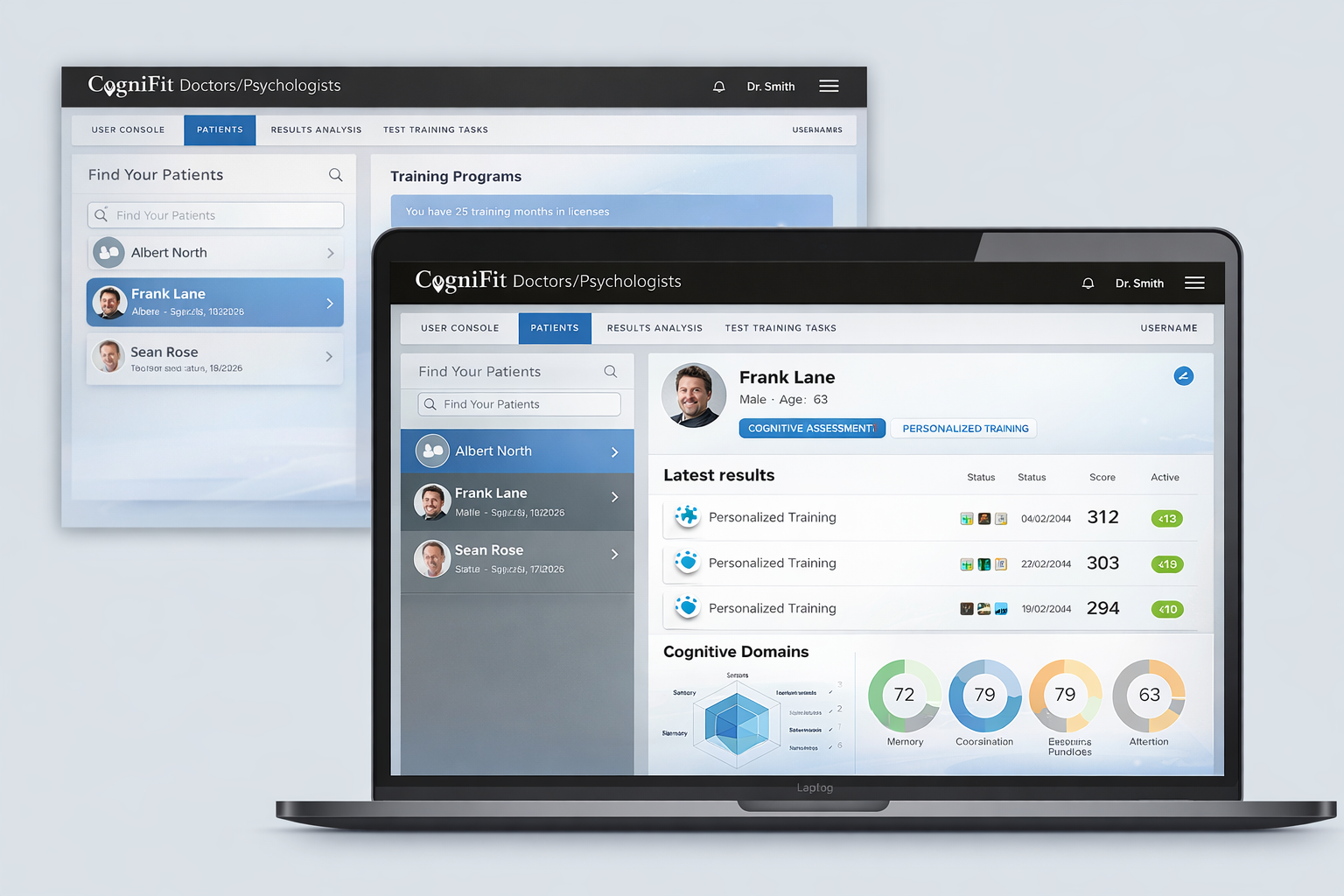

4. Платформы для тренировки когнитивных способностей

Онлайн-программы когнитивной тренировки предлагают научно обоснованные упражнения для развития таких навыков, как память, внимание и гибкость мышления. Хотя они не предназначены для эмоциональной терапии, они могут помочь улучшить концентрацию и способствовать ощущению ясности мышления и умственной активности в рамках здорового образа жизни.

При регулярном использовании когнитивный тренинг может стать частью более широкой программы ухода за психическим здоровьем, наряду с гигиеной сна, физической активностью и сбалансированным питанием.

Почему човеческая поддержка по-прежнему имеет первостепенное значение

Даже самый продвинутый чат-бот не может воспроизвести терапевтический союз между человеком и квалифицированным специалистом по психическому здоровью. Эмпатия, интуиция, клинический опыт и способность адаптироваться в реальном времени – отличительные черты эффективной психологической поддержки.

Кроме того, люди получают пользу не только от того, что говорит терапевт, но и от того, что их видят, понимают и принимают. Такое глубокое человеческое присутствие невозможно закодировать.

Психическое здоровье – это не просто обработка мыслей, а отношения, травмы, развитие, привязанность и смысл. Эти сложности требуют человеческого осознания и этической ответственности.

Искусственный интеллект в области психического здоровья лучше рассматривать как вспомогательный инструмент – нечто, что может улучшить доступ или структурировать процесс, но не заменить человеческую помощь.

Заключительные мысли: технологии – инструмент, а не лечение

ИИ и чат-боты для психического здоровья не являются заменой терапии и не должны восприниматься как таковые. Однако при осознанном использовании они могут обеспечить полезную структуру, способствовать рефлексии и поддерживать повседневное благополучие.

Самое главное? Знайте пределы инструмента, которым пользуетесь. Используйте ИИ, чтобы упорядочить мысли или развить эмоциональную осознанность, но обращайтесь к специалистам при серьёзных эмоциональных трудностях.

Поддержка психического здоровья не универсальна, и ваше благополучие заслуживает большего, чем просто сценарий.

Информация в этой статье предоставляется исключительно в информационных целях и не является медицинским советом. Для медицинских консультаций обращайтесь к врачу.

Ссылки:

- Vaidyam, A. N., Wisniewski, H., Halamka, J. D., Kashavan, M. S., & Torous, J. B. (2019).

Chatbots and Conversational Agents in Mental Health: A Review of the Psychiatric Landscape.

The Canadian Journal of Psychiatry, 64(7), 456–464. https://doi.org/10.1177/0706743719828977 - World Health Organization. (2021). Global Strategy on Digital Health 2020–2025. Geneva: WHO. https://www.who.int/docs/default-source/documents/gs4dhdaa2a9f352b0445bafbc79ca799dce4d.pdf